RLHF là gì? Ứng dụng như nào trong trí tuệ nhân tạo AI

Trong một thế giới trí tuệ nhân tạo (AI) đang không ngừng phát triển thì RLHF là một bước tiến lớn mang tính đột phá đã được sử dụng để phát triển các mô hình AI như ChatGPT. Trong bài viết này chúng ta sẽ đi sâu vào các ứng dụng của RLHF cũng như các ứng dụng của nó trong lĩnh vực trí tuệ nhân tạo AI mà chúng ta vẫn đang sử dụng hàng ngày.

RLHF là gì?

RLHF-Reinforcement Learning from Human Feedback dịch ra là Học tăng cường từ phản hồi của con người là một kỹ thuật máy học (ML) sử dụng phản hồi của con người để tối ưu hóa và nâng cấp các mô hình, giúp cho việc tự học trở nên hiệu quả hơn. Kỹ thuật này liên quan đến việc sử dụng phản hồi của con người để tạo tín hiệu phần thưởng, sau đó được sử dụng để cải thiện hành vi của mô hình được áp dụng học tăng cường.

RLHF-Reinforcement Learning from Human Feedback

Cách hoạt động của RLHF

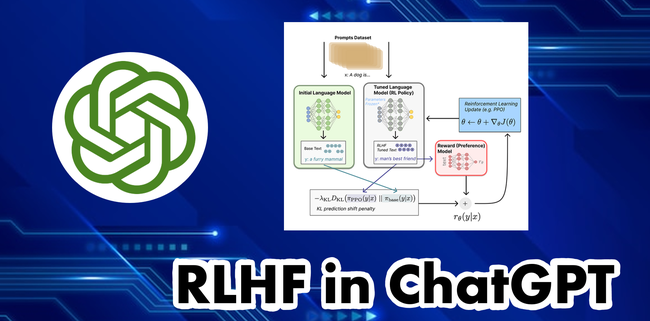

RLHF được thực hiện trong bốn giai đoạn và để dễ hiểu nhất chúng tôi sẽ ví dụ trên mô hình AI như sau:

- Đào tạo mô hình AI ban đầu: Mới đầu, mô hình AI sẽ được sử dụng phương pháp học có giám sát, những người đào tạo sẽ cung cấp cho mô hình những câu trả lời do con người tạo ra. Mô hình AI sẽ học cách dự đoán hành động hoặc đưa ra câu trả lời chính xác dựa trên đầu vào đã cho.

- Thu thập những phản hồi từ con người: Sau khi đã được đào tạo, những người tham gia vào đào tạo mô hình sẽ tiếp tục tham gia cung cấp các phản hồi, đánh giá về hiệu suất của mô hình đó. Mô hình AI sẽ nhận nó để tạo ra tín hiệu phần thưởng cho việc tiếp tục học tăng cường.

- Tối ưu hóa mô hình dựa trên phần thưởng nhận được: Thông qua tín hiệu phần thưởng mô hình sẽ đánh giá một loạt các câu trả lời và đưa ra câu trả lời có khả năng đem lại phần thưởng lớn nhất. Giúp cho người dùng có câu trả lời được tối ưu hóa hơn.

- Tiếp tục quá trình lặp lại: Quá trình thu thập phản hồi của người dùng và tinh chỉnh mô hình thông qua học tăng cường được lặp lại nhiều lần làm cải thiện liên tục hiệu suất của mô hình.

RLHF ứng dụng trong trong Chatbot

Chatbot là các mô hình tiên tiến được đào tạo bằng RLHF. Kỹ thuật này đã đóng góp một vai trò to lớn trong việc cải thiện hiệu suất của các mô hình này và làm cho chúng có khả năng phản ứng giống như một con người.

RLHF ứng dụng trong trong Chatbot

Ví dụ dễ hiểu và gần nhất với người dùng đó là ChatGPT, Các người đào tạo mô hình AI tham gia vào đóng góp dữ liệu cho trợ lý ảo. Sau đó mô hình này sẽ học từ bộ dữ liệu được đóng góp và dự đoán phản hồi phù hợp đến cho người dùng trong cuộc trò chuyện.

RLHF không chỉ dừng lại ở hỗ trợ trong Chatbot mà còn có thể sang các loại AI tạo sinh khác:

- Người dùng có thể sử dụng RLHF trong việc tạo hình ảnh như là đo mức độ chân thực của hình ảnh.

- Trong sáng tác nhạc thì RLHF cũng có thể hỗ trợ tạo ra tác phẩm âm nhạc phù hợp với tâm trạng và trong các hoạt động.

- RLHF còn có thể sử dụng để làm cho mô hình trở nên thân thiện và đáng tin cậy hơn trong những lần người dùng sử dụng.

Những lợi ích của RLHF trong trí tuệ nhân tạo AI

Dựa trên ví dụ được gắn trong mô hình AI ở mục bên trên chúng ta có thể thấy được RLHF mang lại một số lợi thế mạnh khi sử dụng trong hệ thống AI.

Liên tục cải tiến: Quá trình RLHF giúp cải tiến liên tục hiệu suất của mô hình. Mô hình trải qua quá trình học tăng cường ngày càng trở nên tốt hơn trong việc đưa ra những kết quả mà người dùng mong muốn.

Cải thiện hiệu suất: Bằng cách kết hợp với phản hồi của người dùng và nhận đó làm phần thưởng RLHF giúp các hệ thống AI tạo và đưa ra những phản hồi chính xác và phù hợp nhất cho người dùng.

Tăng khả năng thích nghi trong mọi môi trường: RLHF giúp cho mô hình AI làm quen và thích ứng với nhiều tình huống khác nhau nhờ cách học tăng cường từ kinh nghiệm và của người người đào tạo.

Tính linh hoạt: Tính linh hoạt cho phép các mô hình AI có thể hoạt động tốt trong nhiều môi trường, nhiều ứng dụng khác nhau.

Trong bài viết này chúng ta đã khám phá về “Học tăng cường từ phản hồi của con người(RLHF)”. Đó không chỉ là một bước tiến lớn mà còn là một công cụ mạnh mẽ được sử dụng trong nhiều lĩnh vực đời sống mang lại lợi ích tối đa và tích cực cho người dùng. Tóm lại, RLHF không chỉ là một công cụ hiệu quả trong việc cải thiện hiệu suất của mô hình AI mà còn đại diện cho sự kết hợp sáng tạo giữa học tăng cường và sự tham gia của con người tạo nên những ứng dụng hỗ trợ mạnh mẽ và linh hoạt trong lĩnh vực trí tuệ nhân tạo