Chạy các mô hình AI mạnh mẽ ngay trên máy cục bộ (không cần cloud, không dùng API, không rò rỉ dữ liệu)

Một thử nghiệm để chạy mô hình ngôn ngữ lớn (LLM) trên máy cục bộ. Trong một số trường hợp bạn có thể muốn sở hữu 1 mô hình AI của riêng mình.

Nếu bạn đang tò mò về việc chạy mô hình AI local, hiện nay đã có nhiều công cụ giúp việc này trở nên đơn giản hơn bao giờ hết. Không cần nghiên cứu chuyên sâu, không đòi hỏi GPU mạnh - chỉ cần cài đặt, khởi chạy và bắt đầu việc giao tiếp.

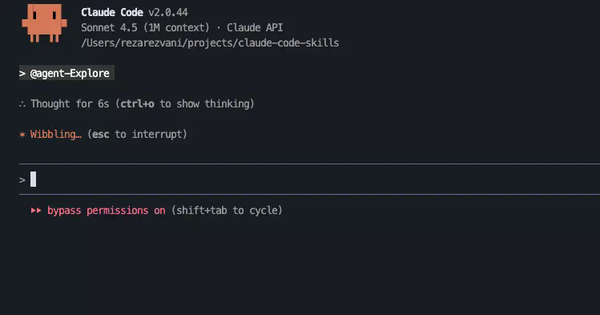

1) Ollama

Ollama là bước khởi đầu lý tưởng – đơn giản, nhanh chóng và không cần thiết lập phức tạp.

curl -fsSL https://ollama.com/install.sh | sh

ollama run llama3

Vậy là xong.

Không có OAuth flow. Không có tokens. Không sao chép API keys từ email. Những vẫn hoạt động bình thường.

Bật mí mẹo hay: bạn có thể gặp một local endpoint hoạt động giống như API OpenAI.

Vậy, nếu bạn đã từng có một triển khai tương tự như dưới đây:

import requests

requests.post("http://localhost:11434/api/generate", json={

"model": "llama3",

"prompt": "Explain gravity like I'm five."

})

Vậy là bạn đã có 1 local GPT rồi đó.

Nếu mục tiêu của bạn là sử dụng mô hình thay vì tìm hiểu cách thức hoạt động, bạn có thể bắt đầu với bước trên.

2) LM Studio — Dành cho người thích giao diện thân thiện hơn là dòng lệnh

LM Studio mang lại cảm giác như thể “ChatGPT được cài ngay trong máy tính của bạn.”

LM Studio cho phép giám sát hiệu năng GPU/CPU theo thời gian thực, giúp người dùng theo dõi rõ ràng mức sử dụng tài nguyên của hệ thống trong quá trình chạy mô hình.

Điểm cộng lớn là LM Studio tương thích tốt với Ollama, nên bạn có thể kết hợp cả hai mà không cần lựa chọn bên nào.

Nếu bạn muốn một trải nghiệm giống như ứng dụng máy tính để bàn thông thường, dễ sử dụng và trực quan, LM Studio là lựa chọn phù hợp nhất.

3) AnythingLLM — Khi trí nhớ trở thành sức mạnh thực sự của mô hình

Một mô hình AI đơn thuần thì thú vị.

Nhưng một mô hình có thể đọc được tài liệu PDF, ghi chú, nhật ký và các tài liệu thì đó là một bước tiến vượt trội.

AnythingLLM biến một mô hình AI chạy cục bộ thành trợ lý nghiên cứu cá nhân, có khả năng hiểu ngữ cảnh và dữ liệu riêng của bạn.

Không cần nhúng dữ liệu lên đám mây, và cũng không có những thông báo bảo mật mơ hồ kiểu “file của bạn sẽ được xử lý an toàn.”

Tất cả chỉ diễn ra trên máy tính với dữ liệu của bạn, cùng quá trình ghi nhớ cục bộ.

Nếu nói về công cụ có thể thực sự thay đổi cách bạn làm việc và tổ chức thông tin, thì AnythingLLM chính là cái tên đáng để bắt đầu.

4) llama.cpp — “Động cơ” để chạy mọi thứ

Tất cả các công cụ ở trên đều được xây dựng dựa trên llama.cpp — nền tảng cốt lõi mang lại sức mạnh thực sự cho các mô hình AI chạy cục bộ.

Công cụ có thể chạy mượt mà trên Mac, ThinkPad, thậm chí cả Raspberry Pi, do đó đem lại hiệu quả làm việc cao.

Không phải là công cụ thân thiện nhất, nhưng chắc chắn là một trong những công cụ mạnh mẽ nhất.

Hãy thử tìm hiểu và tùy chỉnh khi bạn muốn:

- Thay đổi phiên bản lượng tử hóa (quantization variants) phù hợp với cấu hình phần cứng.

- Tinh chỉnh hiệu suất tùy chỉnh để tối ưu tốc độ hoặc bộ nhớ.

- Khai thác nhiều sức mạnh trí tuệ hơn từ cùng một thiết bị.

- Đối với công cụ này, bạn có thể hiểu là nó không bắt buộc nhưng sẽ giúp bạn hiểu rõ cách mọi thứ vận hành ở cấp độ sâu hơn.

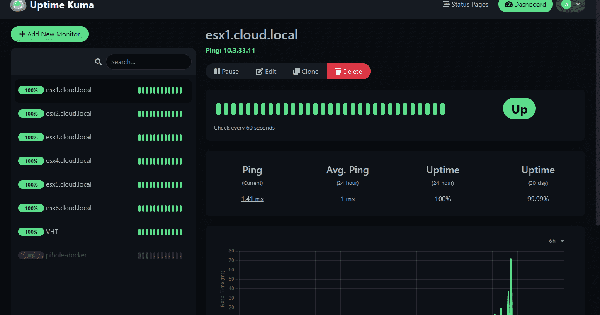

5) Open WebUI — ChatGPT phiên bản của riêng bạn (chạy ngay trong trình duyệt)

Open WebUI là mảnh ghép để toàn bộ trải nghiệm trở nên trọn vẹn.

Với nền tảng này, bạn có thể:

- Làm việc trong không gian trò chuyện đa phiên (multi-chat workspace)

- Lưu và truy xuất lịch sử hội thoại

- Chia sẻ quyền truy cập cho team nếu cần

- Không có bất kỳ thành phần nào phụ thuộc vào cloud

Open WebUI có giao diện tương đối quen thuộc, giống như các ứng dụng trò chuyện AI thông thường. Nhưng điểm khác biệt sẽ trở nên rõ ràng ngay khi bạn bắt đầu thực hiện. Tất cả những câu hỏi hay thông tin trao đổi của bạn đều ở lại trong máy của bạn.

Đôi điều về việc chạy AI ở môi trường riêng, độc lập

Thực ra vấn đề ở đây không phải là ẩn danh hay che giấu mà là quyền sở hữu.

Cloud AI nghĩa là:

Bạn thuê trí tuệ.

Bạn cần quyền để sử dụng tài nguyên tính toán.

Dữ liệu của bạn trở thành "tài liệu đào tạo".

Local AI nghĩa là:

Mô hình nằm trong RAM của bạn.

Các cuộc hội thoại không bao giờ lọt ra khỏi disk của bạn.

Và không có meter nào đang chạy trong nền.

Đây không chỉ là vấn đề bảo mật, mà là vấn đề về quyền kiểm soát và chủ quyền dữ liệu trong kỷ nguyên AI. Vì vậy thử nghiệm nho nho nhỏ này có thể là 1 bước để giúp bạn bắt đầu thực hiện ý định của mình.

Bizfly Cloud tham khảo & tổng hợp